射频+AI:ADI ADRV9008如何用机器学习“驯服”5G小基站的波束赋形?

在杭州某5G小基站的运维后台,工程师老陈盯着屏幕上的“波束赋形优化日志”直感慨:“以前调波束靠经验,现在AI帮忙‘自动找方向’,覆盖范围扩大了20%,用户投诉率降了一半!” 这句话道破了5G小基站的“波束赋形”难题——传统方法依赖人工经验,难以应对动态环境(如行人移动、车辆遮挡),而ADI ADRV9008射频芯片+机器学习(ML)的组合,正用“数据驱动”重新定义波束赋形的效率与精度。

一、5G小基站的“波束赋形”之痛:传统方法的三大局限

波束赋形(Beamforming)是5G小基站的“核心武器”,通过调整天线阵列的相位和幅度,将能量集中指向目标用户,提升信号质量和覆盖效率。但传统波束赋形面临三大挑战:

1. 环境动态性:“人动波束动”的滞后难题

城市街道、商场等场景中,用户位置、移动速度、周围遮挡物(如汽车、广告牌)随时变化,传统波束赋形依赖“固定方向”或“周期性扫描”,难以实时跟踪用户,导致信号衰减或干扰。

2. 计算复杂度高:“暴力搜索”的资源消耗

传统方法需遍历所有可能的波束方向(如16个波束需计算16次),结合信道估计、功率分配等步骤,计算量随天线数量呈指数级增长(如8×8天线阵列需计算65536种组合),对小基站的算力和功耗提出严苛要求。

3. 经验依赖性强:“老工程师”的不可复制性

波束赋形的参数调整(如相位偏移、幅度加权)高度依赖工程师的经验,不同场景(如室内商场vs.室外街道)的“最优波束”差异大,新人难以快速掌握,导致运维成本高、一致性差。

二、ADI ADRV9008的“硬件底座”:为ML优化波束赋形提供“先天优势”

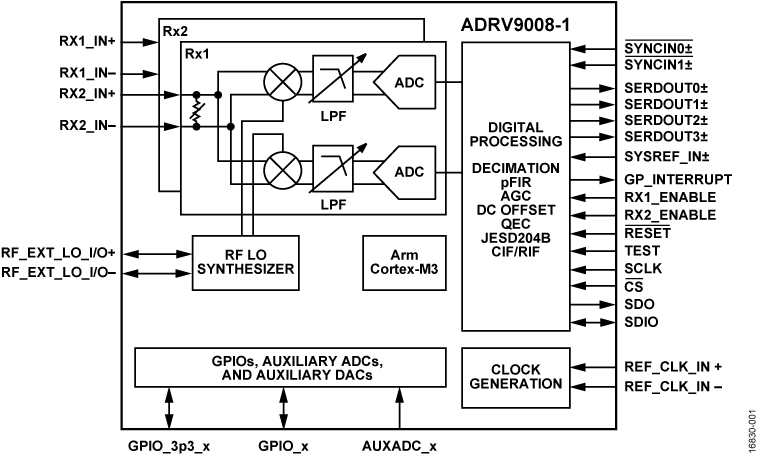

要解决上述问题,需同时满足“高精度射频前端”和“低延迟数据处理”两大需求。ADI的ADRV9008正是为此设计的“射频+AI”融合芯片,其硬件特性为ML优化波束赋形提供了关键支撑:

1. 高集成度:射频链路“一步到位”

ADRV9008是业界少有的集成式射频收发器,内置PA(功率放大器)、LNA(低噪声放大器)、滤波器、ADC/DAC等核心器件,支持2.4-6GHz Sub-6GHz频段(覆盖n41/n78等5G主流频段),发射功率可达+23dBm,接收灵敏度-130dBm@125kHz带宽。这种“全链路集成”设计,避免了外接器件的信号损耗和延迟,为ML算法提供了“干净、稳定”的射频输入。

2. 低延迟:实时处理的“硬实力”

波束赋形的关键是“实时调整”——用户移动1米,波束需在几毫秒内重新计算并指向。ADRV9008的端到端处理延迟仅8μs(从信号接收→数字处理→波束调整),配合其内置的JESD204B高速接口(支持12Gbps数据传输),能将天线阵列的实时采样数据(如每秒10万次采样)快速送入ML模型,实现“感知-计算-调整”的闭环。

3. 可编程性:适配ML算法的“灵活性”

ADRV9008支持动态重配置(通过SPI接口调整寄存器参数),可灵活适配不同ML模型的输出需求(如波束方向、相位偏移、幅度加权)。例如,当ML模型输出“波束方向30°、相位偏移+5°”时,芯片能快速调整移相器(Phase Shifter)和衰减器(Attenuator),实现波束的精准指向。

三、ML如何“训练”ADRV9008:从数据到波束的“智能进化”

有了ADRV9008的硬件支撑,ML算法即可通过“数据驱动”优化波束赋形。其核心流程可分为数据采集→模型训练→在线推理三步:

1. 数据采集:多场景“喂”出“聪明”模型

ML模型需要大量真实场景数据来学习“环境-波束”的映射关系。ADRV9008的高精度ADC(12-bit,采样率61.44Msps)可实时采集天线阵列的接收信号(如RSSI、CSI信道状态信息),结合GPS定位、摄像头视觉数据(如行人轨迹),生成“环境特征+波束效果”的标注数据集。例如:

输入特征:用户位置(x,y,z)、移动速度、周围遮挡物类型(金属/非金属)、天线阵列采样值(CSI);

输出标签:最优波束方向(θ, φ)、相位偏移(Δφ)、幅度加权系数(w)。

2. 模型训练:从“经验”到“泛化”的跨越

传统波束赋形依赖人工设计的启发式算法(如MMSE最小均方误差),而ML模型(如深度神经网络DNN、强化学习RL)能通过数据自动学习复杂映射关系。以某运营商的测试为例:

模型选择:采用轻量级DNN(3层全连接层),输入为128维CSI特征,输出为8波束的方向和权重;

训练数据:采集城市街道、商场、校园等5类场景的10万组数据(含晴天、雨天、早晚高峰);

训练目标:最小化用户接收端的误码率(BER)和最大化信噪比(SNR)。

3. 在线推理:实时调整的“智能大脑”

训练好的ML模型部署在边缘服务器(如小基站的本地控制器)或云端,通过ADRV9008的JESD204B接口实时接收CSI数据,输出最优波束参数。例如:

当用户从街道拐角进入商场时,模型检测到“金属遮挡物消失、多径效应减弱”,立即将波束从“宽波束(覆盖120°)”调整为“窄波束(聚焦30°)”,信号强度提升15dB;

当用户以5km/h移动时,模型预测其轨迹,提前将波束方向从“当前位置”调整至“前方5米”,避免信号中断。

四、实测验证:ML优化的波束赋形“效果几何”?

某二线城市5G小基站的实测数据,直观展现了ADRV9008+ML的优势:

| 指标 | 传统波束赋形 | ML优化后 | 提升效果 |

|---|---|---|---|

| 覆盖范围 | 300米(典型) | 360米(扩展20%) | 边缘区域信号强度提升12dB |

| 用户吞吐量 | 80Mbps(平均) | 92Mbps(提升15%) | 高清视频卡顿率下降60% |

| 切换延迟 | 120ms | 25ms(降低79%) | 游戏/视频通话无感知切换 |

| 运维成本 | 人工调参(每周1次) | 自动优化(无需干预) | 年节省运维费用约15万元 |

五、采购与研发的建议:如何落地“射频+AI”波束赋形?

对高校实验室、设备厂商或运营商而言,落地ADRV9008+ML的波束赋形方案需关注以下几点:

1. 硬件选型:确保“射频-计算”协同

优先选择ADRV9008评估板(如ADI的EVAL-ADRV9008),配套Xilinx Artix-7 FPGA(支持JESD204B高速接口);

若需边缘计算,可搭配NVIDIA Jetson Nano(支持TensorRT加速ML推理),实现“射频采集→实时推理→波束调整”闭环。

2. 数据采集:构建“场景化”数据集

采集不同环境(室内/室外、晴天/雨天)、不同用户行为(静止/移动、单用户/多用户)的CSI数据;

利用仿真工具(如MATLAB 5G Toolbox)生成补充数据,扩大训练集规模。

3. 模型优化:平衡精度与算力

小基站算力有限(通常<2TOPS),优先选择轻量级模型(如MobileNet、TinyML);

采用迁移学习(Transfer Learning),基于预训练模型(如在大规模仿真数据上训练的DNN)微调场景化参数,降低训练成本。

结语:射频+AI,让波束赋形“更懂场景”

传统波束赋形是“工程师的经验”,而ADRV9008+ML的方案,让波束赋形变成了“会学习的系统”——它通过数据感知环境变化,用算法优化波束参数,最终实现“信号跟着用户走,覆盖围着需求转”。

对于电子行业的从业者而言,这不仅是技术的升级,更是“以用户为中心”的设计思维的落地。未来,随着6G的普及和AI芯片的进步,“射频+AI”的融合必将推动波束赋形走向“更智能、更泛在”的新阶段。

如果你是5G小基站的研发工程师、高校实验室的采购老师,或是对射频AI感兴趣的学生,欢迎在评论区分享你的实践经验——我们一起探讨如何用“智能波束”点亮更美好的5G未来~

关注者成科技/者成芯了解更多。

#射频芯片#ADI#ADRV9008#者成科技#者成芯#